Projekt- und Portfolio-Management auf Abruf

Durch das Angebot, PPM-Software als Software-as-a-Service beziehen zu können, ist die Einstiegshürde niedrig

Eine gute PPM-Lösung erlaubt aus Sicht der Unternehmensstrategie die Planung und Auswahl sowie die kontinuierliche Kontrolle und Bewertung des Projektportfolios

Von Peter Säckel, CA Deutschland

(25.01.10) - In Zeiten wirtschaftlicher Unsicherheit sind Führungskräfte angehalten, einen schnellen Return on Investment (ROI) aus den IT-Investitionen oder Entwicklungsprojekten zu erzielen. Als Steuerungs-Tool eignen sich hierzu insbesondere Lösungen für das Projekt- und Portfolio-Management (PPM). Der Betrieb nach dem Software-as-a-Service (SaaS)-Modell erlaubt den flexiblen, Budget-schonenden Einstieg.

Nie waren sie wertvoller! Im Antlitz wankelmütiger Wirtschaftslaunen hilft Software für ein umfassendes Projekt- und Portfolio-Management – kurz PPM –, die Investition auf die strategisch wichtigen Aufgaben zu konzentrieren. Mit ihrer Hilfe gewinnen Unternehmen den notwendigen Über- und Einblick, um in Zeiten der Ressourcenknappheit die richtigen Entscheidungen zu treffen. Und durch das Angebot, PPM-Software nach Bedarf – also auf Abruf – als Software-as-a-Service beziehen zu können, ist die Einstiegshürde niedrig. Unternehmen können so kostenintensive Investitionen in Technologien vor Ort und risikobehaftete Entwicklungs- oder Implementierungsaufwände vermeiden und sich auf die Nutzung, sprich das Management anstehender Projekte, konzentrieren. Ein "Pay as You Go"-Angebot ist insbesondere dann ideal, wenn es sich um einmalige Vorhaben handelt. Der US-Konzern Kellogg steuerte beispielsweise mit PPM als SaaS die Einführung einer umfangreichen Personal-Management-Lösung, um Zeit und Budget des mehrere Millionen Dollar-schweren Projektes im Griff zu behalten.

Wofür steht Projekt- und Portfolio-Management konkret?

Die grundsätzlichen Idee hinter PPM ist denkbar einfach: Bereits ein einziges schlecht durchgeführtes Projekt kann einem Unternehmen teuer zu stehen kommen. Ausufernde Kosten, schwindende Glaubwürdigkeit bei den Kunden und frustrierte Mitarbeiter belasten hier schnell die Wettbewerbsstärke. Selbst ein optimal durchlaufendes Projekt wird zum Investitionsgrab, wenn sich das Projektziel nicht im Einklang mit den Geschäftszielen befindet. Sind mehrere Vorhaben gleichzeitig zu steuern, gehen ohne geeignete Werkzeugunterstützung Durch- und Überblick schnell verloren. Mangelnde Transparenz kann bei konkurrierenden Forderungen nach Finanzmitteln, Mitarbeitern und Ressourcen schnell zu Fehlentscheidungen führen.

Dem Vorbild der Finanzwirtschaft folgend ebnen PPM-Lösungen den Weg, Investitionen an den Unternehmenszielen auszurichten. Der Portfolio-Ansatz dient dabei als Wegweiser, Finanzen, Ressourcen und Personal optimal einzusetzen. Im Unterschied zum traditionellen Projekt-Management, das die Verwaltung einzelner Projekte zur Aufgabe hat, stehen die vollständige Koordination der projektübergreifenden Prozesse und die optimale Zuteilung der knappen Ressourcen im Mittelpunkt. Dabei werden sowohl strategische als auch operative Anforderungen – wie Projektauswahl/-priorisierung und Umsetzung im Rahmen eines Multiprojekt-Managements – unterstützt. In ihrer vollständigen Ausprägung verbindet PPM-Software das Top-down-Vorgehen aus der Portfolio-Perspektive mit dem Bottom-up-Verfahren aus der Projektsicht. Ein optimales Portfolio-Management bindet die Informationen aus Anforderungs- und Projekt-Management, der Ressourcenplanung sowie des Zeit- und Kosten-Managements mit ein und macht die Zusammenhänge als auch den aktuellen Status der Projekte transparent.

Der Hinweis auf die Vollständigkeit ist mit Bedacht gewählt. In zweierlei Hinsicht! Zum einem muss der Funktionsumfang einer PPM-Software die Gepflogenheiten eines Unternehmens widerspiegeln. Besonderes Augenmerk gilt hierbei den Prozessen, die bei der Abwicklung von Projekten eingehalten werden sollen. Bewährte Verfahren müssen dabei einfach und schnell in das PPM-System einbindbar sein. Zum zweiten muss eine Integration in andere unverzichtbare Lösungen des Unternehmens, zum Beispiel in ein ERP-System, möglich sein. Gerade die Nutzung von Synergien hilft, die Amortisation der PPM-Lösung zu beschleunigen.

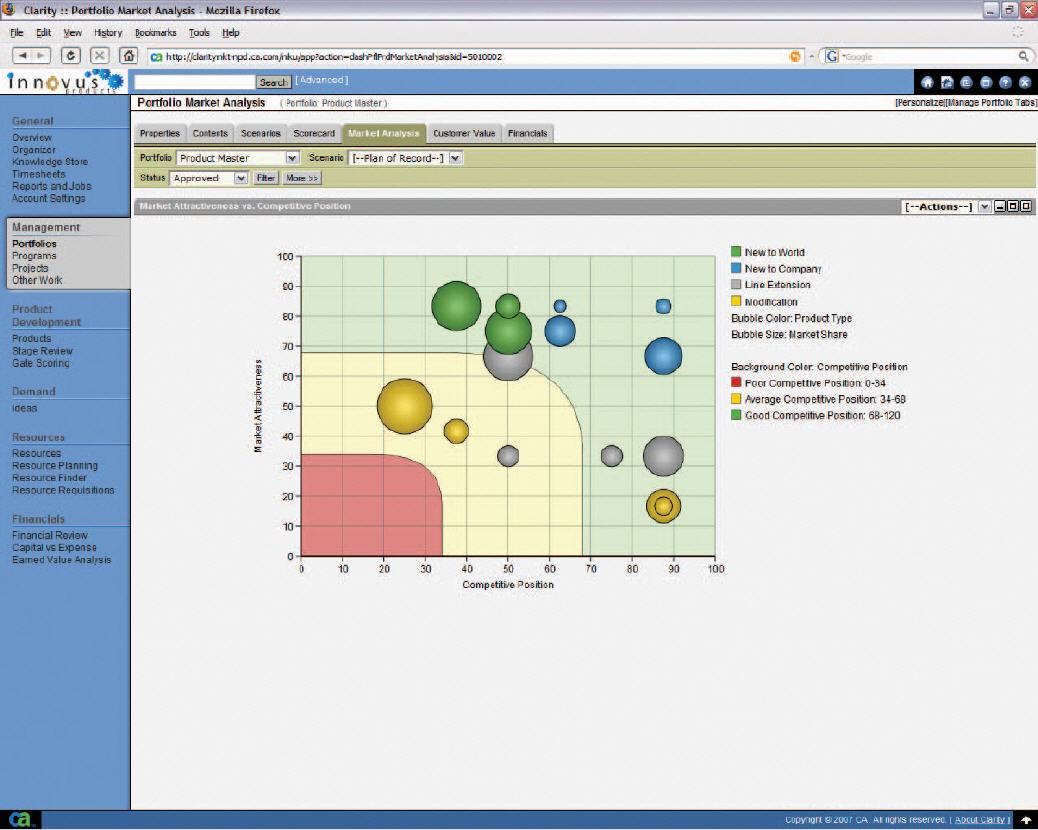

Eine gute PPM-Lösung erlaubt aus Sicht der Unternehmensstrategie die Planung und Auswahl sowie die kontinuierliche Kontrolle und Bewertung des Projektportfolios. Dies ist gerade bei ungeplanten Arbeiten bzw. unvorgesehenen Ereignissen besonders kritisch und wichtig. Eine Produktidee und Projektanforderungen lässt sich so aus strategischer Sicht kategorisieren, im Rahmen einer Portfolio-Analyse ("Was wäre, wenn"-Szenario) bewerten und im Anschluss automatisch in die Projektplanung sowie Ressourcenzuordnung transformieren. In Echtzeit lässt sich auf Leistungsdaten per Drilldown bis in die Details des taktisch geprägten Tagesgeschäfts zugreifen.

Auf diese Weise geben die Lösungen Antworten auf wichtige Fragen wie "Befinden sich alle Ressourcen im Einklang mit den strategischen Initiativen?", "Reicht mein Budget aus?" oder "Erzielen wir den im Auswahlprozess angestrebten Nutzen?". Der Einbezug tagesaktueller Projektinformationen mit den Eckdaten neuer Vorhaben in die Portfolio- und Anforderungsanalyse beantwortet Fragen wie "Was ist zu tun, wenn sich der geplante Workload für ein Projekt X verdoppelt?" oder "Welche Folgen hat die zehnprozentige Budgetkürzung?" und "In welchem Projekt sind Verzögerungen akzeptabel und welches Projekt muss vorrangig behandelt werden?".

Die Verantwortlichen können mit diesem Wissen, die richtigen Entscheidungen für oder gegen neue Maßnahmen oder Projekte treffen. Anstatt sich in der Auswahl von subjektiven Kriterien wie dem Bauchgefühl leiten zu lassen, basiert die Entscheidung zu Budgetverschiebungen oder veränderter Personal- und Ressourcen-Zuordnung nun auf nachvollziehbaren Informationen. IT-Abteilungen werden befähigt, Vorgaben wie IT-Governance besser umzusetzen und die Entwicklung neuer Produkte zu optimieren. Dazu kommen eine verbesserte Effizienz in der Projektbearbeitung und eine schnellere Amortisierung. Zugleich kann dem Controlling jederzeit nachgewiesen werden, dass jeder Euro, jede Personalstunde und jede Infrastrukturkomponente dem Unternehmen zu Gute kommen. (CA: ra)

Autoren-Info:

Peter Säckel ist Senior Consultant bei CA Deutschland GmbH.

CA Technologies: Kontakt und Steckbrief

Der Informationsanbieter hat seinen Kontakt leider noch nicht freigeschaltet.